¿Qué es un Modelo de Lenguaje de Gran Escala (LLM)?¶

- Son modelos de inteligencia artificial entrenados con millones de textos.

- Aprenden patrones del lenguaje y pueden predecir la siguiente palabra (token) en una frase.

- Se usan para traducir, resumir, responder preguntas, generar código y mucho más.

Características clave:¶

- Entrenados con enormes volúmenes de texto.

- Versátiles: sirven en muchas áreas (educación, salud, negocios).

- Multilingües y adaptables.

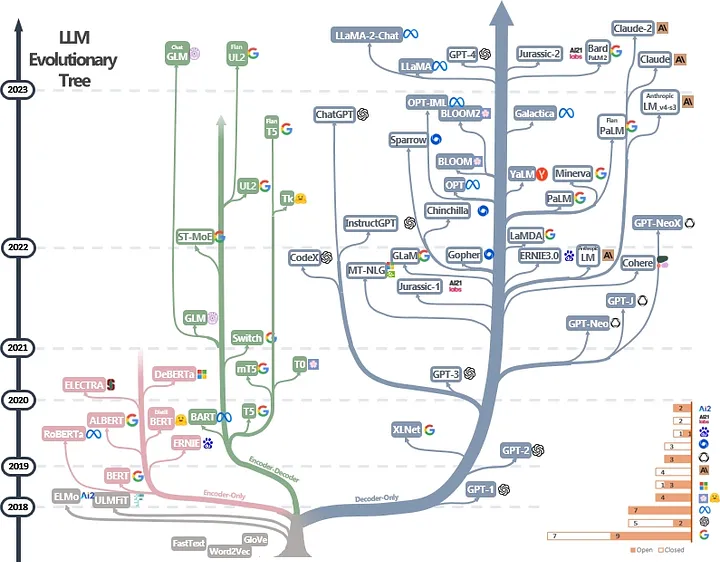

Historia breve de los LLM¶

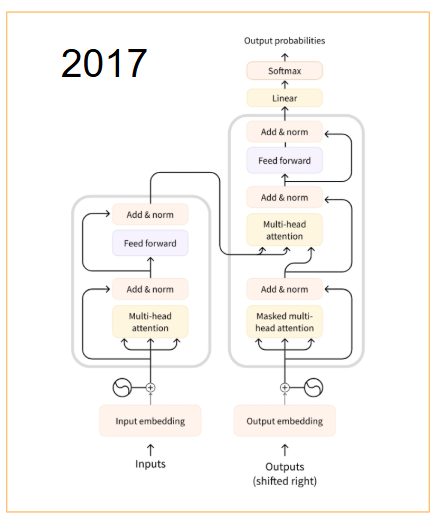

Transformers y GPT¶

Los Transformers revolucionaron el procesamiento del lenguaje al permitir modelos que entienden el contexto completo de una oración. Sobre esta base, nacen modelos como GPT (Generative Pre-trained Transformer), capaces de generar texto coherente, responder preguntas y mucho más.

Evalocuión de los LLM¶

Los modelos de lenguaje se evalúan con métricas como exactitud, coherencia y utilidad, y se comparan en benchmarks estandarizados. Además, se utilizan tareas prácticas (traducción, clasificación, QA) para medir su rendimiento real.

¿Cómo representar una palabra?¶

Representación textual¶

Transcribir texto es guardar letras como bits. Para eso, usamos estándares como ASCII y UTF-8. Veamos cómo funcionan:

ASCII

- 1 byte (8 bits): 128 caracteres posibles.

- Rango numérico:

0 (48)...9 (57) - Letras:

A (65)...Z (90),a (97)...z (122) - ❗ Problema: No incluye letras como Ñ, á, ó, emojis, etc.

UTF-8

- De 1 a 4 bytes (8 a 32 bits).

- Compatible con ASCII.

- Soporta múltiples alfabetos (latino, griego, árabe, chino...).

- ✅ Incluye emojis, símbolos y muchos caracteres especiales.

Ejemplo en código Python:

def mostrar_codificacion(texto):

print(f"{'Char':<5} {'ASCII':<6} {'ASCII Bin':<10} {'UTF-32 Bin'}")

for c in texto:

val = ord(c)

ascii_bin = bin(val)[2:].zfill(8)

utf32 = ' '.join(bin(val)[2:].zfill(32)[i:i+8] for i in range(0, 32, 8))

print(f"{c:<5} {val:<6} {ascii_bin:<10} {utf32}")

# Ejemplo

mostrar_codificacion("Hola Mundo!")

Char ASCII ASCII Bin UTF-32 Bin

H 72 01001000 00000000 00000000 00000000 01001000

o 111 01101111 00000000 00000000 00000000 01101111

l 108 01101100 00000000 00000000 00000000 01101100

a 97 01100001 00000000 00000000 00000000 01100001

32 00100000 00000000 00000000 00000000 00100000

M 77 01001101 00000000 00000000 00000000 01001101

u 117 01110101 00000000 00000000 00000000 01110101

n 110 01101110 00000000 00000000 00000000 01101110

d 100 01100100 00000000 00000000 00000000 01100100

o 111 01101111 00000000 00000000 00000000 01101111

! 33 00100001 00000000 00000000 00000000 00100001

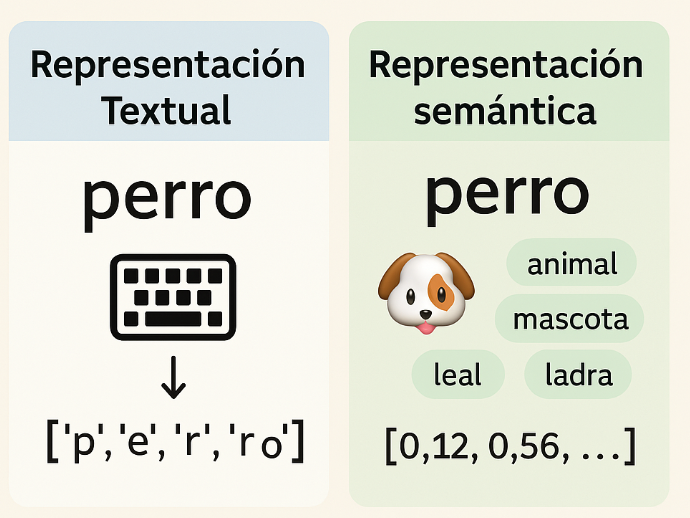

Representación semántica¶

La representación semántica busca capturar el significado de las palabras, no solo su forma escrita. A diferencia de codificaciones como ASCII, aquí el objetivo es entender qué quiere decir una palabra en su contexto.

Podemos representarla de dos formas:

- Como una unidad completa, asociada a un significado global.

- Dividiéndola en tokens, es decir, partes con sentido que ayudan a construir su significado total.

Este enfoque permite a los modelos de lenguaje trabajar con el sentido de las palabras, no solo con su ortografía.

Veamos un ejemplo:

¿Cómo funciona un LLM?¶

Una mirada informal: el LLM en acción

A veces, la mejor forma de empezar es con humor. Esta imagen resume de manera graciosa lo que hace un LLM:

Como puedes ver, el modelo está "sosteniéndose" sobre el tren del texto.

¿Por qué? Porque su tarea es simple en apariencia, pero compleja en ejecución: predecir la siguiente palabra en función del contexto anterior.

Del texto a los tokens

Antes de poder generar texto, el modelo necesita convertir las palabras en tokens.

Los LLM no entienden directamente frases como "Hola, ¿cómo estás?", sino que las transforman en unidades más pequeñas llamadas tokens.

Cada token puede ser una palabra, una sílaba, o incluso una letra, dependiendo del idioma y del modelo.

Cada uno de estos tokens se representa como un número entero que el modelo puede procesar.

El viaje de los tokens por el modelo

Una vez convertidos en números, los tokens recorren las distintas capas del modelo.

Estas capas aplican transformaciones matemáticas para capturar el significado y las relaciones entre palabras.

El modelo evalúa el contexto completo antes de decidir cuál es el siguiente token más probable.

Cada uno de estos pasos refleja cómo la información fluye por la arquitectura del modelo, que suele estar basada en Transformers.

Este tipo de arquitectura es capaz de identificar patrones complejos y relaciones entre palabras en distintos lugares del texto.

El proceso de decodificación

Después de procesar los tokens, el modelo genera un nuevo token —el que cree que debe venir a continuación— y repite el proceso.

Así, palabra a palabra, el modelo construye oraciones, párrafos e incluso textos enteros.

Asistentes Virtuales Inteligentes¶

Los asistentes virtuales impulsados por IA están transformando cómo interactuamos con la tecnología en nuestra vida diaria. Permiten automatizar tareas, brindar soporte personalizado y mejorar la eficiencia en diversos sectores.

Asistentes más destacados:

¿Qué podemos hacer?:

- Educación: actuar como tutores virtuales.

- Salud: asistir en consultas o diagnósticos preliminares.

- Contenido: redactar textos, resumir artículos, generar ideas.

- Software: ayudar a escribir o corregir código.

- Atención al cliente: responder preguntas frecuentes o resolver problemas comunes.

Introducción a los Prompts¶

Un prompt es una instrucción o entrada que se entrega a un modelo de lenguaje como ChatGPT para que realice una tarea. Puede ser una pregunta, una orden, una petición de resumen, generación de código, traducción, entre muchas otras opciones.

Diseñar un buen prompt es clave para obtener respuestas útiles, claras y relevantes.

Tipos de Prompts¶

Existen diferentes formas de formular prompts, dependiendo del objetivo:

| Tipo de Prompt | Ejemplo | Respuesta Esperada |

|---|---|---|

| Pregunta directa | ¿Qué es la inteligencia artificial? | La inteligencia artificial es una rama de la informática que busca crear sistemas capaces de realizar tareas que normalmente requieren inteligencia humana, como el aprendizaje, el razonamiento o la percepción. |

| Instrucción | Escribe una historia breve sobre un robot que viaja al futuro. | Érase una vez un robot llamado A-12 que fue enviado al año 3024. Allí descubrió un mundo gobernado por inteligencia artificial avanzada, donde los humanos y máquinas convivían en armonía... |

| Comando técnico | Genera un código en Python para ordenar una lista de números. | python\nnumeros = [5, 2, 9, 1]\nnumeros.sort()\nprint(numeros)\n# Resultado: [1, 2, 5, 9] |

¿Qué es un Buen Prompt?¶

Un buen prompt debe ser:

- Claro y específico

- Contextualizado (si es necesario)

- Detallado en cuanto a los requisitos

- Adaptado al público objetivo

Veamos dos ejemplos para comparar:

Ejemplo 1: Prompt simple

Haz un código en Python para ordenar una lista.

Resultado esperado: Un ejemplo genérico, sin explicaciones ni contexto adicional. Este tipo de prompt puede ser útil para tareas muy puntuales, pero suele generar resultados básicos.

Ejemplo 2: Prompt estructurado

Eres un profesor de programación enseñando a estudiantes principiantes.

Tu tarea es crear un ejemplo en Python para ordenar una lista de números.

Explica paso a paso el código, usando comentarios.

Utiliza dos métodos: el método `.sort()` y el algoritmo de burbuja.

Incluye ejemplos de entrada y salida.

El objetivo es ayudar a los estudiantes a comprender ambos enfoques.

Resultado esperado: El modelo entrega un código bien explicado, con comentarios, ejemplos y una estructura pensada para enseñanza. El resultado es más completo, útil y adaptado al propósito educativo.

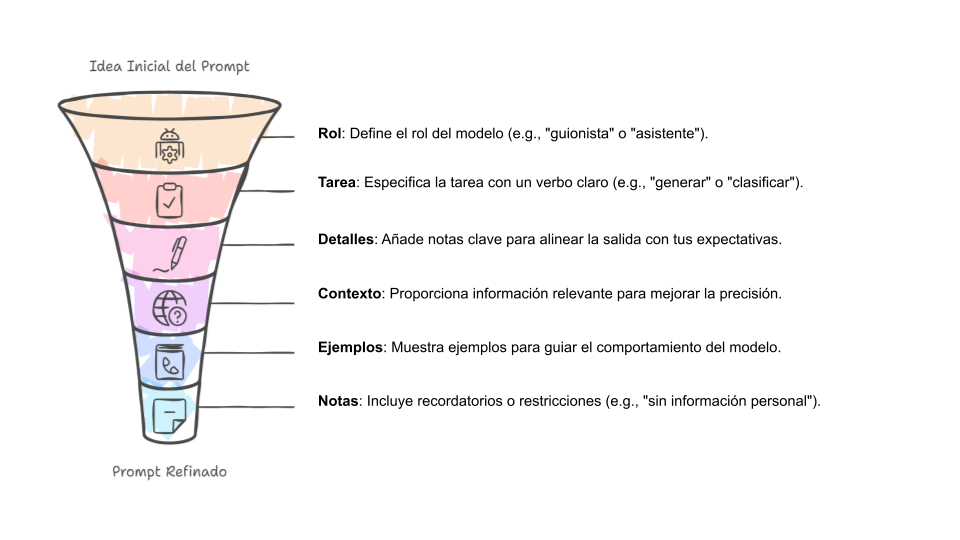

Elementos de un Buen Prompt

Los siguientes componentes pueden mejorar significativamente la calidad de un prompt:

- Rol asignado: Definir quién es el modelo (por ejemplo, un profesor, un asesor legal, un científico).

- Tarea clara: Explicar qué se espera como salida (resumen, código, tabla, análisis, etc.).

- Nivel de detalle: Agregar condiciones específicas, formato de salida, estilo, nivel de dificultad.

- Contexto: Especificar para quién es el resultado (por ejemplo, para un niño, un experto, un cliente).

- Ejemplos o restricciones: Cuando es necesario, se pueden incluir ejemplos, formatos, o límites de longitud.

Técnicas de Prompting¶

A la hora de interactuar con modelos de lenguaje, no basta con hacer una pregunta. Existen diferentes estrategias de prompting que permiten guiar al modelo para obtener mejores resultados. Estas técnicas varían en complejidad y en el grado de información que proporcionan al modelo.

Estrategias comunes:

| Técnica | Descripción | Ejemplo | Respuesta esperada |

|---|---|---|---|

| Zero-shot | Se formula una instrucción sin ejemplos ni contexto adicional. | Explica qué es la fotosíntesis. | La fotosíntesis es el proceso mediante el cual las plantas convierten la luz solar en energía química, utilizando agua y dióxido de carbono. |

| Few-shot | Se incluyen uno o más ejemplos para que el modelo los use como guía. | Traduce al francés: Hello → Bonjour, Thank you → Merci, Good morning → ? | Good morning → Bonjour |

| Chain-of-Thought | Se solicita una respuesta explicando paso a paso el razonamiento utilizado. | Un tren viaja a 80 km/h y recorre 240 km. ¿Cuánto tiempo tarda? Explica tu razonamiento. | El tren recorre 240 km a 80 km/h. Aplicamos la fórmula: tiempo = distancia / velocidad. Entonces: 240 / 80 = 3. El tren tarda 3 horas. |

| Chaining | Se divide una tarea compleja en varios prompts encadenados, usando la salida de uno como base. | 1. Resume la Revolución Industrial en 3 frases. 2. Expande cada frase en un párrafo. | Se genera un resumen en frases clave (por ejemplo: mecanización, urbanización, transporte), y luego se desarrolla cada una como un párrafo detallado. |

Actividad sugerida¶

Para practicar el diseño de prompts, se puede realizar el siguiente ejercicio:

- Elegir un asistente de IA (por ejemplo, ChatGPT, Gemini o DeepSeek).

- Escribir un prompt básico sobre un tema de interés.

- Mejorar ese prompt utilizando los elementos vistos anteriormente.

- Comparar las respuestas obtenidas con ambos prompts.

- Repetir la prueba en diferentes asistentes para observar diferencias en resultados y estilos de respuesta.

Esta práctica ayuda a entender cómo pequeños cambios en la redacción pueden impactar significativamente en la calidad de las respuestas generadas por el modelo.